Microsoft Fabric é uma gama abrangente de recursos em nuvem dedicados à análise de dados, que inclui diferentes etapas como transferência, armazenamento, processamento, integração e análise de dados, bem como inteligência empresarial e análise em tempo real.

O Microsoft Fabric é uma solução de análise de dados baseada em SaaS que integra diversos componentes do Microsoft Power BI, Azure Synapse e Azure Data Factory em torno de um lago de dados central chamado OneLake.

O Microsoft Fabric engloba diversas áreas como movimentação, armazenamento e análise de dados, integração, ciência de dados, análise em tempo real e inteligência de negócios, além de segurança, governança e conformidade de dados. Pode-se dizer que o Fabric é a proposta da Microsoft em resposta ao Google Cloud Dataplex. Atualmente, o Fabric está em fase de pré-visualização.

O Microsoft Fabric é destinado a um amplo público, incluindo administradores, desenvolvedores, engenheiros de dados, cientistas de dados, analistas de dados, analistas de negócios e gerentes. Atualmente, o Microsoft Fabric é automaticamente ativado para todos os usuários do Power BI.

O Microsoft Fabric Data Engineering combina Apache Spark com o Data Factory, permitindo a programação e coordenação de notebooks e trabalhos do Spark. A Fabric Data Factory une o Power Query com a escala e potência da Azure Data Factory, suportando mais de 200 conectores de dados. A Ciência de Dados da Tecido se integra com o Azure Machine Learning, possibilitando o rastreamento de experimentos e registro de modelos. O Fabric Real-Time Analytics inclui um fluxo de eventos, um banco de dados KQL (Kusto Query Language) e um conjunto de consultas KQL para executar, visualizar e personalizar resultados de consultas sobre dados. Se o KQL é algo novo para você, seja bem-vindo ao grupo.

Página inicial do Microsoft Fabric mostrando os links para diferentes ferramentas como Power BI, Data Factory, Data Activator, Synapse Data Engineering, Synapse Data Science, Synapse Data Warehouse e Synapse Real-Time Analytics.

Uma situação ou acontecimento.

OneLake é um lago de dados unificado e centralizado destinado a toda a sua empresa; cada usuário tem acesso a um único lago de dados. A finalidade do OneLake é servir como o principal repositório para todos os dados de análise, de forma similar à proposta da Microsoft com o OneDrive para armazenar todos os seus arquivos. Para facilitar a utilização do OneLake em seu computador, é possível instalar o explorador de arquivos OneLake para Windows.

O OneLake, desenvolvido no Azure Data Lake Storage (ADLS) Gen2, é capaz de aceitar qualquer formato de arquivo. Porém, os diversos elementos de dados da Fabric, como data warehouses e data lakehouses, são configurados para armazenar automaticamente seus dados no formato OneLake no Delta, baseado no Apache Parquet, o qual é também utilizado pelo Azure Databricks. Assim, independentemente se os dados foram originados pelo Spark ou SQL, eles são consolidados em um único lago de dados no formato Delta.

Para criar uma casa de dados OneLake, o processo é fácil: Basta mudar para a visualização de Engenharia de Dados, criar e dar um nome a uma nova casa de lago, e depois carregar alguns arquivos CSV na seção de arquivos do lago de dados.

Na perspectiva da engenharia de dados da plataforma Microsoft Fabric, é possível visualizar tanto arquivos quanto tabelas. As tabelas estão armazenadas no formato Delta Parquet. Ao escolher um arquivo, é disponibilizado um menu com três pontos para realizar diversas operações com o arquivo, como por exemplo, carregá-lo em uma tabela.

Atualmente, transferir dados para as mesas na casa do lago pode ser mais complicado do que se espera. Embora o recurso Load to Tables pareça ser a solução, falhou nos testes iniciais que realizei. Após receber ajuda do suporte da Microsoft, descobri que, até o momento desta escrita, a função Load to Tables não consegue lidar com títulos de colunas que contenham espaços. Embora outras plataformas de casas de lago consigam lidar com isso facilmente, a funcionalidade ainda está em fase de desenvolvimento. Acredito que essa capacidade será incluída no produto final.

Eu decidi me dedicar a utilizar arquivos CSV sem erros e consegui realizar uma consulta Spark SQL em um notebook em relação a uma tabela recém-criada.

Os laptops de tecido são compatíveis com Python e SQL e, neste caso, utilizamos o Spark SQL para visualizar os dados de uma tabela do OneLake.

O Spark não é a única forma de realizar consultas SQL nas tabelas do Lakehouse. É possível acessar as tabelas no formato Delta no OneLake por meio de um endpoint SQL, que é gerado automaticamente ao implantar o Lakehouse. Esse endpoint SQL se refere à mesma cópia física da tabela Delta no OneLake e proporciona uma experiência semelhante ao T-SQL. Em resumo, é como utilizar o Azure SQL em vez do Spark SQL.

No futuro, será possível observar que o OneLake tem capacidade para abrigar tanto Data Warehouses baseados em Synapse quanto Lakehouses. Os Data Warehouses são mais adequados para usuários com conhecimento em T-SQL, embora os usuários Spark também consigam acessar dados nos armazéns. É possível estabelecer conexões diretas no OneLake para que as Lakehouses e os data warehouses possam acessar tabelas sem a necessidade de duplicar os dados.

Medida de intensidade de corrente elétrica.

O Power BI foi melhorado para ser compatível com tabelas OneLake Lakehouse (Delta). Além das funções tradicionais de análise de dados e criação de relatórios de negócios, o Power BI também pode se integrar ao Microsoft 365.

Um relatório do Power BI foi criado no Microsoft Fabric, onde todas as principais funcionalidades do Power BI foram transferidas para a interface.

Produção de informações

A plataforma Data Factory da Microsoft Azure une a funcionalidade de integração de dados cidadã e profissional. Ela suporta a conexão a diversos tipos de bases de dados, data lakes, data warehouses e interfaces genéricas, permitindo a importação de dados através de fluxos de dados e a realização de transformações em larga escala com mais de 300 opções. Além disso, é possível utilizar o editor de consultas de energia e aplicar extração de dados a partir dessas consultas.

Eu experimentei um processo de transferência de dados que importou e modificou duas tabelas do banco de dados Northwind. Fiquei surpreso com as funcionalidades, mas a última etapa da publicação não teve sucesso. Tudo bem, está em fase de visualização.

Você pode utilizar pipelines de dados para elaborar sequências de ações que envolvem desde a extração de dados até o armazenamento em locais específicos, passando pela execução de diferentes tarefas como notebooks e scripts SQL. Consegui com êxito importar dois conjuntos de dados de exemplo, referentes a feriados e passeios de táxi em Nova York, e salvá-los em repositórios de dados. No entanto, não verifiquei a capacidade de atualizar o pipeline de forma regular.

Se necessitar transferir dados para o OneLake localmente, futuramente será possível estabelecer um gateway de dados local e conectá-lo a um fluxo de dados. Como alternativa provisória, é possível copiar os dados locais para a nuvem e carregá-los de lá.

Estimulador de Informações

Segundo a Microsoft, o ativador de dados é uma função do Microsoft Fabric que executa ações automaticamente ao detectar padrões ou condições específicas nos dados. Essa ferramenta monitora os dados em relatórios do Power BI e eventos do Eventstreams, e quando os dados atingem determinados limites ou padrões predefinidos, ela realiza ações apropriadas automaticamente, como notificar usuários ou iniciar fluxos de trabalho no Power Automate.

Exemplos comuns de situações em que o ativador de dados é utilizado incluem a exibição de anúncios quando as vendas de uma loja específica estão em queda, a notificação dos gerentes de uma loja para realocar produtos perecíveis nos freezers antes que estraguem e o aviso às equipes de contas quando os clientes estão com pagamentos atrasados, com limites personalizados de tempo ou valor para cada cliente.

A disciplina de Engenharia de Dados

A maior parte do conteúdo abordado na seção OneLake se refere principalmente à engenharia de dados. Dentro do Microsoft Fabric, a Engenharia de Dados engloba aspectos como a arquitetura do lago, as configurações de trabalho do Apache Spark, as ferramentas de programação (Python, R, Scala e SQL) e os fluxos de dados (abordados na seção Data Factory acima).

Análise de informações utilizando métodos estatísticos e tecnológicos para obter insights e tomar decisões.

A Ciência de Dados no Microsoft Fabric engloba modelos de aprendizado de máquina, experimentos e cadernos. Existem aproximadamente seis cadernos de amostras disponíveis. Optei por executar a amostra do modelo de previsão de série temporal, que utiliza Python, a biblioteca Profeta (desenvolvida pelo Facebook), MLflow e o recurso de Autologging do Fabric. A amostra de previsão de séries temporais utiliza o conjunto de dados de vendas de imóveis em NYC, que deve ser baixado e posteriormente carregado em um repositório de dados.

O Profeta adota uma abordagem convencional de previsão de séries temporais com base em sazonalidade, o que contrasta com a crescente complexidade dos modelos de aprendizado de máquina e aprendizagem profunda. O processo de montagem e previsão foi concluído em 147 segundos, ou seja, menos de três minutos.

Previsão de vendas de imóveis após a organização dos dados de vendas de imóveis em Nova York para um modelo sazonal chamado Profeta.

Depósito de informações

O Armazém de Dados do Microsoft Fabric pretende unir os conceitos de lagos de dados e armazéns de dados. Ele difere do SQL Endpoint dos lagos de dados, que é um armazém apenas para leitura criado automaticamente ao criar uma casa de lago no Microsoft Fabric. Por outro lado, o Data Warehouse é um armazém de dados convencional que oferece suporte a recursos transacionais T-SQL, como qualquer armazém de dados empresarial.

Diferentemente do SQL Endpoint, que cria tabelas e dados de forma automática, o Data Warehouse permite que você tenha total controle sobre a criação de tabelas, carregamento, transformação e consulta de dados no armazém de dados, utilizando o portal Microsoft Fabric ou comandos T-SQL.

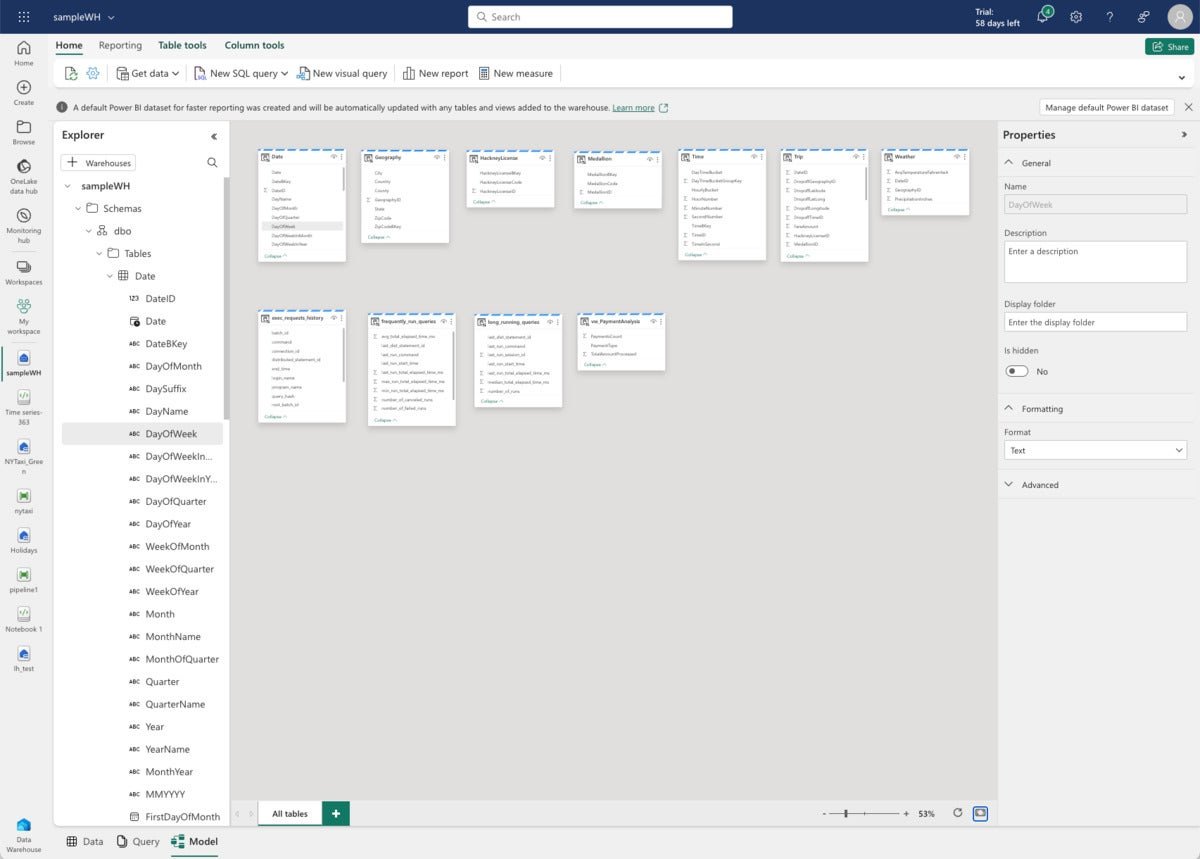

Elaborei um novo depósito de dados e o preenchi com informações de exemplo fornecidas pela Microsoft. Essas informações consistem em mais um conjunto de dados de viagens de táxi (de um ano distinto), porém organizadas em tabelas de depósito de dados. Além disso, a Microsoft disponibiliza alguns scripts SQL de exemplo.

Visualização antecipada dos dados do Armazém de Dados de Tecido para uma tabela. Observe as mensagens referentes ao conjunto de dados do Power BI gerado automaticamente na parte superior.

Visualização do modelo de dados do Data Warehouse na tela.

Visualização de busca de dados de armazenamento de tecido. A Microsoft incluiu o script SQL como parte do exemplo.

Exame em tempo imediato.

O Real-Time Analytics no Microsoft Fabric está fortemente ligado ao Azure Data Explorer, de modo que os links de documentação atualmente direcionam para a documentação desse serviço. É garantido que a documentação do Real-Time Analytics está passando por atualizações.

O Real-Time Analytics e o Azure Data Explorer fazem uso de bancos de dados e consultas realizadas na Linguagem de Consulta Kusto (KQL). Comparado ao SQL Server, um RDBMS transacional, consultar dados no Kusto é significativamente mais veloz, especialmente quando se trata de grandes volumes de dados, chegando a bilhões de linhas. O nome “Kusto” foi inspirado em Jacques Cousteau, renomado explorador submarino francês.

Utilizei um exemplo da Microsoft, referente a análises meteorológicas, para aprender sobre o KQL e a Análise em Tempo Real. Esse exemplo conta com um script contendo diversas consultas em KQL.

A coleção de demonstrações Fabric Real-Time Analytics atualmente inclui seis exemplos diferentes, com conjuntos de dados que vão de 60 MB para análises do clima até quase 1 GB para trajetos de táxi em Nova York.

A consulta KQL utilizada na captura de tela apresentada é atrativa devido ao seu emprego de funções geoespaciais, resultando em um gráfico de dispersão.

Mesmo com 60 MB de dados, esta pesquisa geoespacial realizada no KQL foi concluída em apenas um terço de um segundo.

Ampla abrangência e análise detalhada.

Enquanto encontrei vários problemas ao testar a funcionalidade do Microsoft Fabric, pude perceber a extensão de suas capacidades e recursos analíticos avançados. Se for devidamente desenvolvido e refinado, ele pode se tornar um concorrente à altura do Google Cloud Dataplex.

O Microsoft Fabric é adequado para todos? Não tenho certeza. No entanto, posso afirmar que a Fabric facilita a visualização da área de interesse atual através do switcher de visualização na interface, semelhante à forma como o Adobe Photoshop atende a diferentes públicos. Infelizmente, o Photoshop é conhecido por ser poderoso, mas difícil de dominar. Resta saber se a Fabric terá uma reputação semelhante no futuro.