LangChain oferece benefícios como um código limpo e simples, e a capacidade de trocar modelos com poucas alterações. Vamos experimentar LangChain com o extenso modelo de linguagem PaLM 2.

Grandes modelos de linguagem (LLMs) tornaram-se uma parte essencial do conjunto de software, podendo ser acessados por meio de APIs de empresas como Cohere, Google Cloud e OpenAI, ou como modelos de código aberto disponíveis no Hugging Face.

Entretanto, o uso de LLMs vai além de simplesmente enviar estímulos. É fundamental que os desenvolvedores levem em conta fatores como ajustes de parâmetros, ampliação de estímulos e controle das respostas. Como os LLMs são desprovidos de memória, os desenvolvedores precisam manter o registro da conversa para manter o contexto, possivelmente recorrendo a bancos de dados para armazenamento duradouro.

Adicionalmente, não existe uma solução padrão para Aprendizado de Máquina. Diferentes aplicações podem necessitar de múltiplos modelos especializados, o que torna a integração mais complexa e o desenvolvimento mais complicado.

LangChain está se tornando a principal opção para desenvolvedores que criam aplicações de alta qualidade impulsionadas por LLMs. Seu ecossistema abrangente e ativo reúne diversos fornecedores, como o modelo de linguagem avançado PaLM2 do Google.

Neste guia, iremos mostrar os passos para criar uma aplicação LangChain utilizando o modelo Google PaLM 2.

Organização do espaço físico

Acesse o Google MakerSuite e gere uma chave de API para o PaLM.

No terminal, configure um ambiente virtual Python e o habilite.

Defina uma variável de ambiente para guardar a chave de API do PaLM.

Instale os módulos Python listados a seguir.

Entrando na interface de programação da API PaLM.

Comece um novo Jupyter Notebook (em seu computador local ou no Google Colab) e rode o código a seguir.

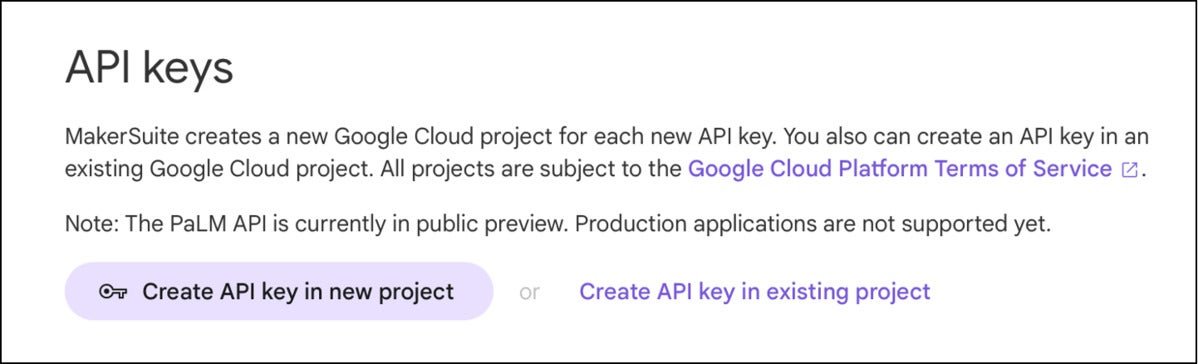

O programa inicia importando os módulos Python e depois busca a chave API da variável ambiente. Em seguida, utiliza o método create_text, especificando o modelo como modelos/text-bison-001 e fornecendo o prompt como variável.

A temperatura é um fator determinante na previsão do modelo, sendo que valores próximos de zero resultarão em saídas mais previsíveis e determinísticas.

Ele produz o resultado mencionado.

O modelo forneceu uma resposta detalhada após ser orientado a explicar a diferença com um exemplo, de acordo com as instruções do prompt.

A seguir, vamos realizar a mesma atividade com LangChain.

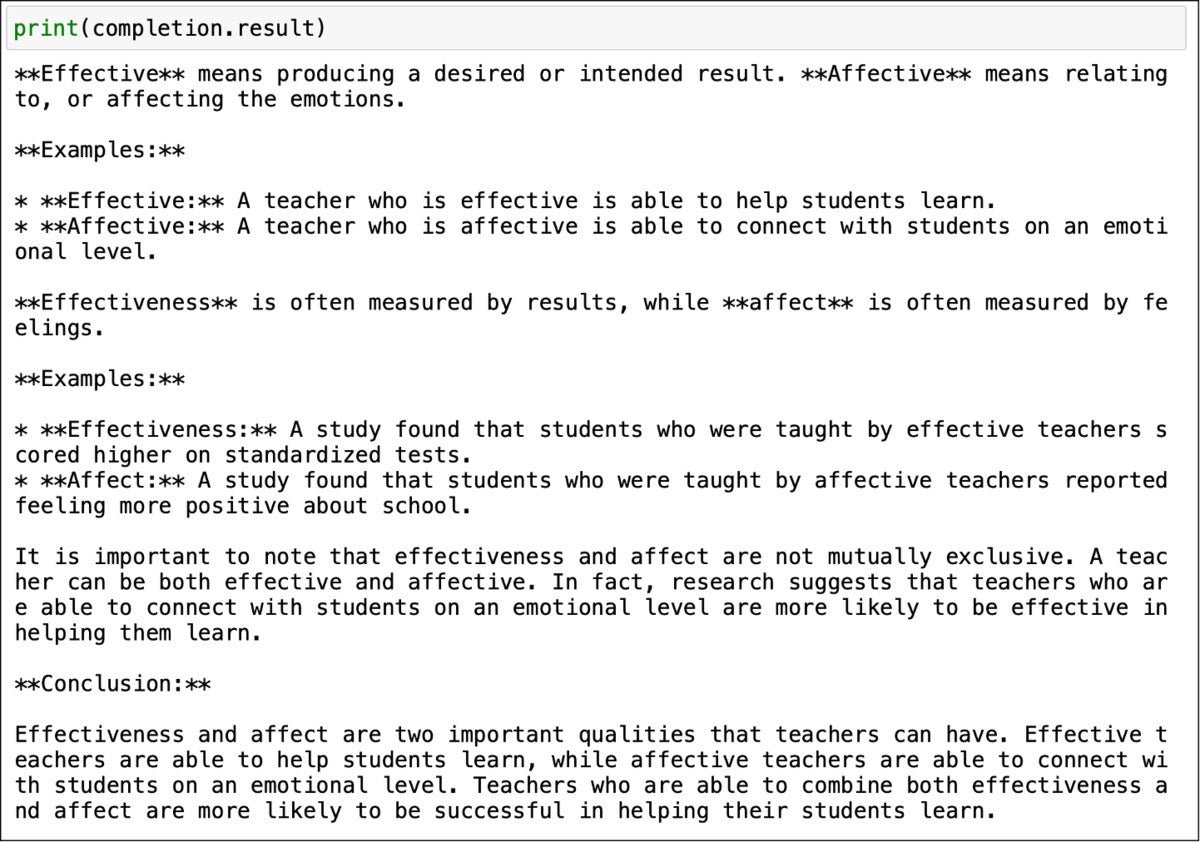

Comece um novo Jupyter Notebook e rode o código a seguir.

O código não apenas está mais organizado, mas também é mais fácil de compreender. Começa atribuindo o valor da variável llm ao modelo Google PaLM e, em seguida, estabelece a temperatura.

No LangChain, a variável prompts é uma lista em Python. É possível enviar diversos prompts de uma vez e retroceder várias gerações.

Uma vez que estamos lidando com apenas um prompt, estamos acessando a propriedade de texto da primeira geração.

Podemos observar que a saída é idêntica à do programa anterior.

O propósito deste guia foi apresentar a API PaLM e como ela se integra perfeitamente com o LangChain. A principal vantagem dessa estratégia é a habilidade de substituir o LLM com poucas alterações no código. Ao utilizar o LangChain, o LLM passa a ser um dos componentes da cadeia que pode ser facilmente trocado.

Na próxima etapa desta série, iremos desenvolver um aplicativo LangChain Q&A com base em um arquivo PDF personalizado. Mantenha-se informado.

Esta coleção

- Iniciar com a interface de programação de aplicativos (API) PaLM do Google.

- Desenvolva um assistente de conversação utilizando a interface de programação de aplicativos (API) PaLM do Google.

- Simplificar a busca por similaridade utilizando a API PaLM do Google.

- Um pequeno manual para programadores de software sobre LangChain.